| Gruppe | Thema | Studierende |

|---|---|---|

| A | 📚 Digital disconnection | Kofer, Rieger |

| B | 📦 Automatic text analysis (Topic Modeling & Netzwerkanalyse) | Köbler, Mühlmeister, Neudecker |

| C | 📚 Media routines & habits | Budak, Knapp, Kuck |

| D | 📦 Data collections methods (mit Schwerpunkt Data Donations) | Jakob, Neumeier |

Einführung & Überblick

Session 02

08.11.2023

Agenda

Organisation & -koordination

Allgemeine Infos, Gruppenaufteilung, Abstimmung des Semesterplans & Fragen

Kurzes Update

Allgemeine Infos zum Kurs

📖 Basisliteratur zu den Präsentationen auf StudOn verfügbar!

⏰ Regelmäßige Kontrolle von Zulip

🧮 Denken Sie an die Deadline für das Zertifikat vom R-Basiskurs (13.11.2023)

🗣️ 1. Präsentationsgruppe: Denken Sie an die Zusendung des Entwurf der Präsentationsfolien und das Feedbackgespräch nächste Woche!

Die Würfel sind gefallen

Kurzer Überblick der Gruppenaufteilung

Abstimmung des Semesterplans

Option A Option A |

|||

|---|---|---|---|

| Session | Datum | Topic | Presenter |

Introduction |

|||

1 |

25.10.2023 |

Kick-Off |

Christoph Adrian |

01.11.2023 |

🎃 Holiday (No Lecture) |

||

2 |

08.11.2023 |

Einführung in DBD |

Christoph Adrian |

3 |

15.11.2023 |

🔨 Working with R |

Christoph Adrian |

📂 Project 1 |

Analysis of media content |

||

4 |

22.11.2023 |

📚 Digital disconnection |

Group A |

5 |

29.11.2023 |

📦 Automatic text analysis |

Group B |

6 |

06.12.2023 |

🔨 Text as data in R |

Christoph Adrian |

7 |

13.12.2023 |

📊 Presentation & Discussion |

All groups |

8 |

20.12.2023 |

Buffer Session |

|

🎄Christmas Break (No Lecture) |

|||

📂 Project 2 |

Analysis of media usage |

||

9 |

10.01.2024 |

📚 Media routines & habits |

Group C |

10 |

17.01.2024 |

📦 Data collection methods |

Group D |

11 |

24.01.2024 |

🔨 Working data logs |

Christoph Adrian |

12 |

31.01.2024 |

📊 Presentation & Discussion |

All groups |

13 |

07.02.2024 |

🏁 Recap, Evaluation & Discussion |

Christoph Adrian |

Option B Option B |

|||

|---|---|---|---|

| Session | Datum | Topic | Presenter |

Introduction |

|||

1 |

25.10.2023 |

Kick-Off |

Christoph Adrian |

01.11.2023 |

🎃 Holiday (No Lecture) |

||

2 |

08.11.2023 |

Einführung in DBD |

Christoph Adrian |

3 |

15.11.2023 |

🔨 Working with R |

Christoph Adrian |

🗣️ |

Presentations |

||

4 |

22.11.2023 |

📚 Media routines & habits |

Group C |

5 |

29.11.2023 |

📚 Digital disconnection |

Group A |

6 |

06.12.2023 |

📦 Data collection methods |

Group D |

7 |

13.12.2023 |

📦 Automatic text analysis |

Group B |

8 |

20.12.2023 |

Buffer Session |

|

🎄Christmas Break (No Lecture) |

|||

📂 Project |

Analysis of media content |

||

9 |

10.01.2024 |

🔨 Text as data |

Christoph Adrian |

10 |

17.01.2024 |

🔨 Topic Modeling |

Christoph Adrian |

11 |

24.01.2024 |

🔨 Q&A |

Christoph Adrian |

12 |

31.01.2024 |

📊 Presentation & Discussion |

All groups |

13 |

07.02.2024 |

🏁 Recap, Evaluation & Discussion |

Christoph Adrian |

TL;DR von Option B

Zusammenfassung der Änderungen

Präsentationen in 2023 & Projektarbeit in 2024

nur ein Präsentationstermin mit “Project topic idea(s)”

Fokus auf Analyse von Medieninhalten (Project 1), keine Analyse der Logging-Daten (Project 2)

Aber (Optional): Project 2 light

- Durchführung einer Mini-Studie im Kurs (benötigt Einverständnis)

- Fokus des Projektberichts auf Datenaufbereitung & -exploration

Fragen? Anmerkungen?

Please vote!

Welche Option des Seminarplans bevorzugen Sie?

Bitte scannen Sie den QR-Code oder nutzen Sie folgenden Link für die Teilnahme an einer kurzen Umfrage:

Temporary Access Code: 5623 9279

01:00

Ergebnis

Anything else?

Weitere Fragen zur Organisation oder Ablauf des Kurses

Let’s talk about DBD …

Was sind digital behavior data?

Was ist das eigentlich?

Rückblick auf einen Definitionversuch von Weller (2021)

… fasst eine Vielzahl von möglichen Datenquellen zusammen, die verschiedene Arten von Aktivitäten aufzeichnen (häufig sogar “nur” als Nebenprodukt)

… können dabei helfen, Meinungen, Verhalten und Merkmale der menschlichen Nutzung digitaler Technologien zu erkennen

Und im Kontext des Seminars?

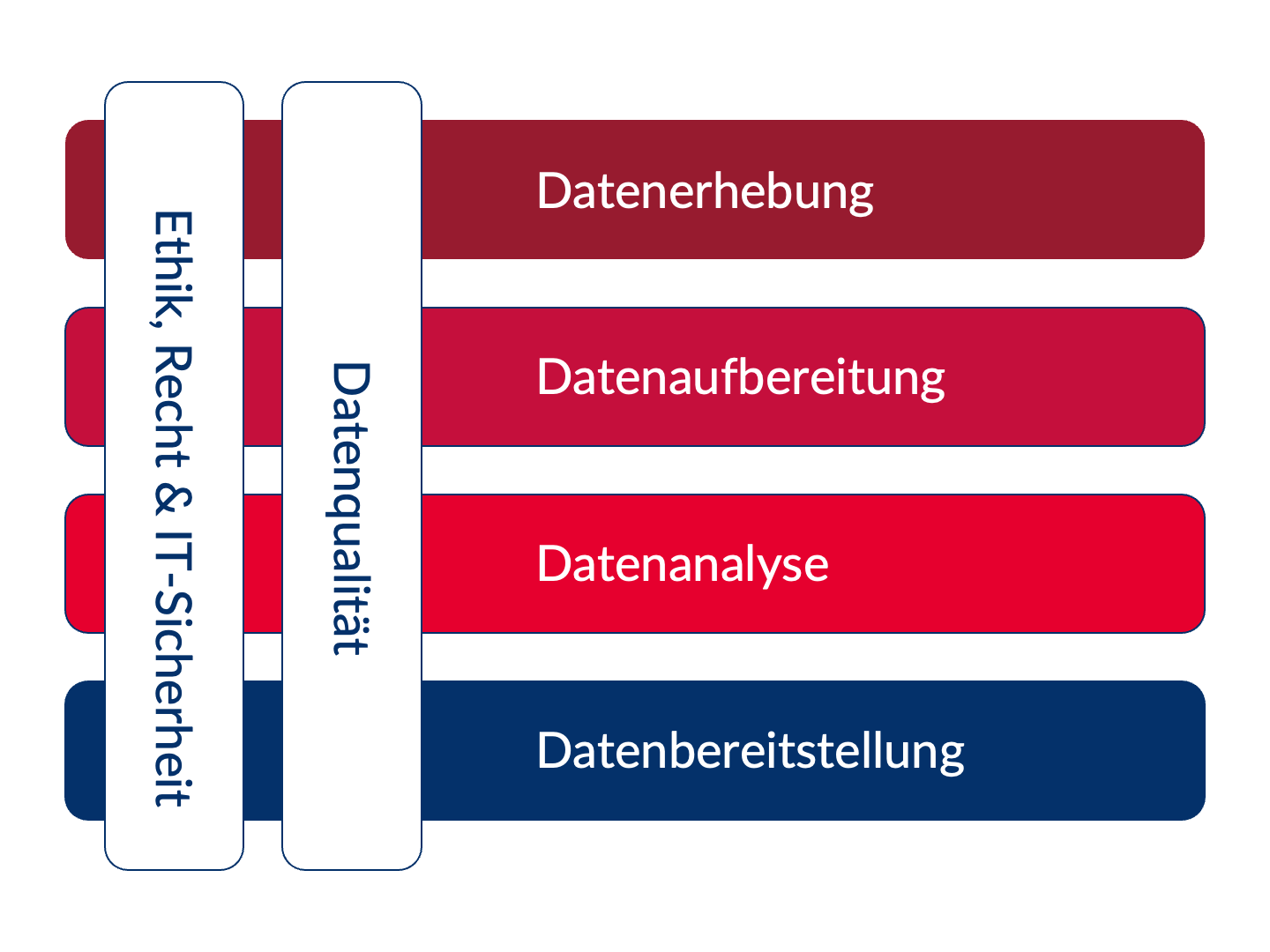

Arbeitsdefinition & Kernbereiche (GESIS) von DBD

- DBD umfasst digitale Beobachtungen menschlichen und algorithmischen Verhaltens,

- wie sie z.B. von Online-Plattformen (wie Google, Facebook oder dem World Wide Web) oder

- Sensoren (wie Smartphones, RFID-Sensoren, Satelliten oder Street View-Kameras) erfasst werden.

- Schwerpunkt: Nutzung und Inhalte von soziale Medien

- Computational Social Science [CSS] Verfahren, z.B. zur Erhebung, Verarbeitung, Auswertung und Präsentation

CSS 🖇️ DBD

Kurzer Exkurs zur Bedeutung von Computational Social Science

Definition (Computational Social Science).

We define CSS as the development and application of computational methods to complex, typically large-scale, human (sometimes simulated) behavioral data.” (Lazer et al., 2020)

hilft dabei …

genuine digitale Phänomene zu untersuchen

digitale Verhaltensdaten zu sammeln und vorzuverarbeiten

neue Methoden zur Analyse von großen Datensätzen anzuwenden

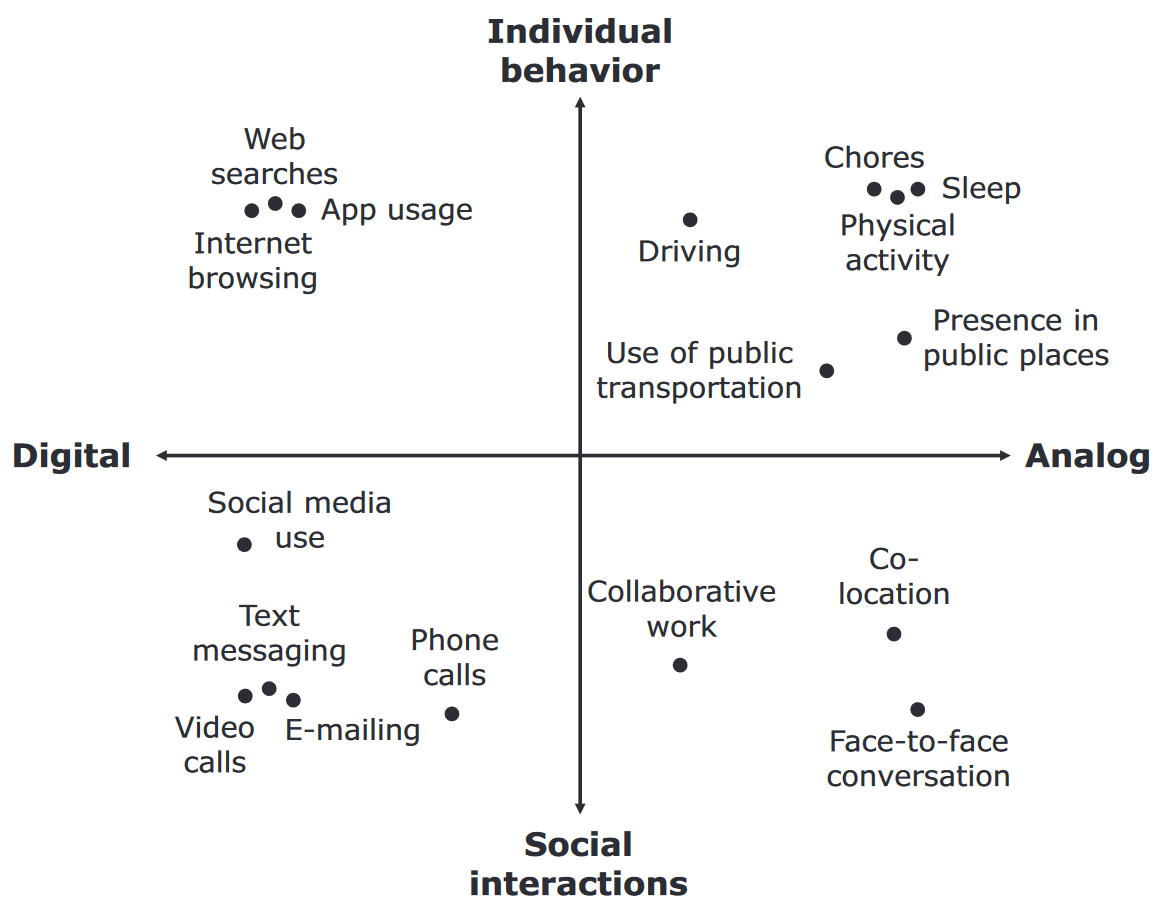

An Abundance Of Possibilities

Und was können wir mit DBD untersuchen?

Von Verhalten bis Interkation

Beispiel für untersuchbare Phänomene samt Einschränkungen

Einschränkungen

- Selektive Nutzung von bestimmten digitalen Geräten bzw. Funktionen

- Kategorisierung ist Momentaufnahme und nicht überschneidungsfrei

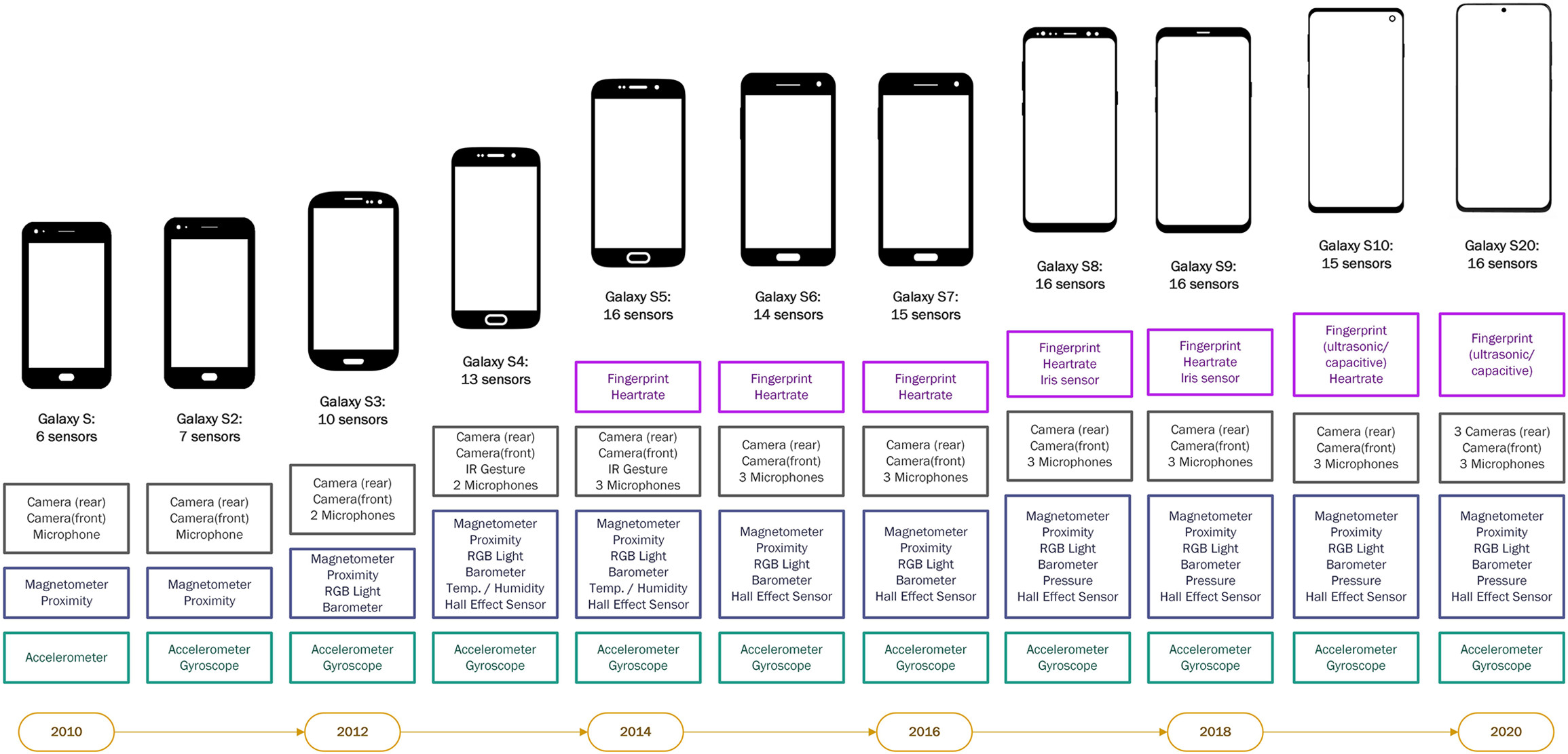

Mehr Daten durch technologischen Fortschritt

Beispiel: Wachsenden Anzahl eingebauter Smartphone-Sensoren

Graphik aus Struminskaya et al. (2020)

Verfügbarkeit als Pluspunkt

DBD als wertvolle Quelle bei aktuellen, sensiblen & unvorhersehbaren Themen

Einsatz besonders Vorteilhaft bei Themen bzw. Untersuchungen …

- … für die es schwierig ist, Studienteilnehmer*innen zu rekrutieren

- … bei denen Beobachtungen vorteilhafter sind als Befragungen

Beispiel: Streaming und/oder Mining von Inhalten aus bestehenden digitalen Kommunikationsströmen

- Zeitnaher als die Erstellung einer Umfrage

- Zusätzlicher Nutzen als Archiv bei unvorhersehbaren Ereignissen

Die Power von Social Sensing

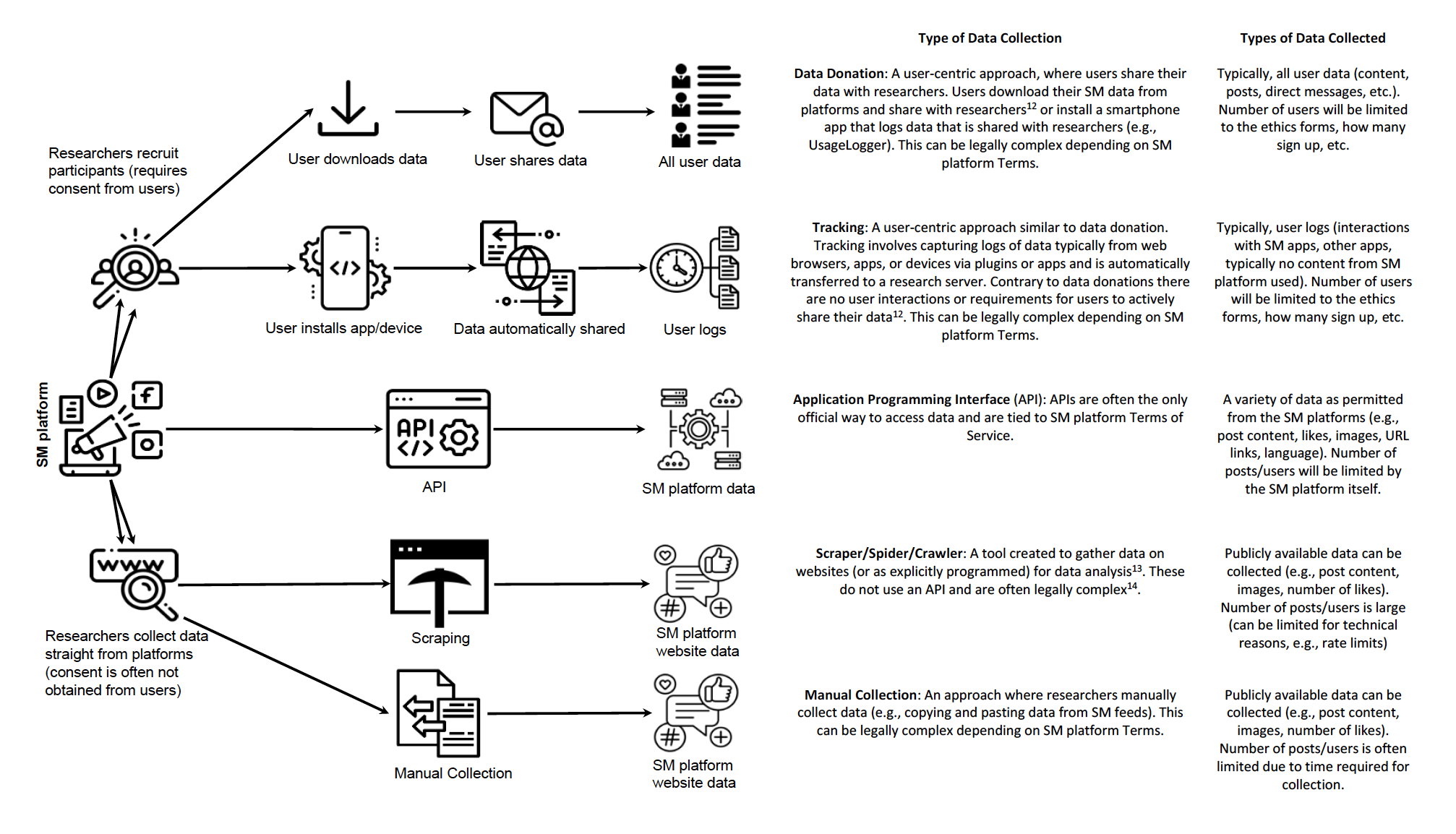

Forschungsdesign zur Erhebung digitaler Verhaltensdaten (Flöck & Sen, 2022)

Mit Fokus auf die Platform

Forschungsdesign zur Erhebung digitaler Verhaltensdaten (Flöck & Sen, 2022)

Online-Plattformen prägen die Gesellschaft

Gründe für den Fokus auf Onlineplattformen (Ulloa, 2021)

vermitteln & formen menschliche Kommunikation (z.B. Tweet mit 280 Zeichen)

politische (Miss-)Nutzung

Gatekeeper für Informationen (z.B. “Dr.Google”)

tägliche algorithmische Empfehlungen und Werbung: Nachrichten, Produkte, Jobangebote, Bewerbungen, Versicherungen, Hotels, …

ABER: Berücksichtigung der Art und Weise, wie Sie die Daten gesammelt werden!

Der Weg bestimmt das Ergebnis

Einfluss der Erhebung auf die Daten(-form) (Davidson et al., 2023)

Wenn der Vorteil zum Nachteil wird

Ambivalenz der Unaufdringlichkeit (Keusch & Kreuter, 2021)

Unterscheidung zwischen aufdringlichen (z.B. spezielle Research-App & Befragungen) & unaufdringlichen (z.B. Cookies, Browserplugins & APIs) erhobenen Daten

Bewertung und Erwartung an Datensammlung ist abhängig vom Kontext (z.B. Amazon vs. Researchgate)

Paradoxes Dilemma

Einerseits bereitwillige (oft unwissende) Abgabe der Daten an Konzerne ohne Wissen um deren Weiterverarbeitung, andererseits häufig Bedenken bezüglich Datenschutz & Privatsphäre bei wissenschaftlichen Studien, die über Verwendung der Daten aufklären.

Eine kleine Lobeshymne auf DBD

Zwischenfazit

Digitale Geräte oder Sensoren können sich an bestimmte Fakten besser “erinnern” als das menschliche Gedächtnis.

Sensoren sind oft bereits in alltägliche Technologie eingebaut und produzieren digitale Verhaltensdaten als ein “Nebenprodukt”.

Unaufdringliche Erfassung als potentieller Vorteil bzw. Entlastung für Teilnehmer*Innen

Kombination mit Umfragedaten möglich (und bereichernd!)

Aber: Berücksichtigung der Rahmenbedingungen!

Zur erfolgreichen Nutzung müssen Forschungsziele & verfügbare Daten in Einklang gebracht, mögliche Biases und methodische Probleme berücksichtigt sowie die Datenqualität evaluiert werden.

Herausforderungen von DBD

Potentielle Biases & ethische und rechtliche Faktoren

The End of Theory

Zur Wichtigkeit von konzipierte Messungen & Designs

“Who knows why people do what they do? The point is they do it, and we can track and measure it with unprecedented fidelity. With enough data, the numbers speak for themselves.” (Anderson, 2008)

Was denken Sie?

“Size alone does not necessarily make the data better” (boyd & Ellison, 2007)

“There are a lot of small data problems that occur in big data [which] don’t disappear because you’ve got lots of the stuff. They get worse.” (Harford, 2014)

We need to talk about biases

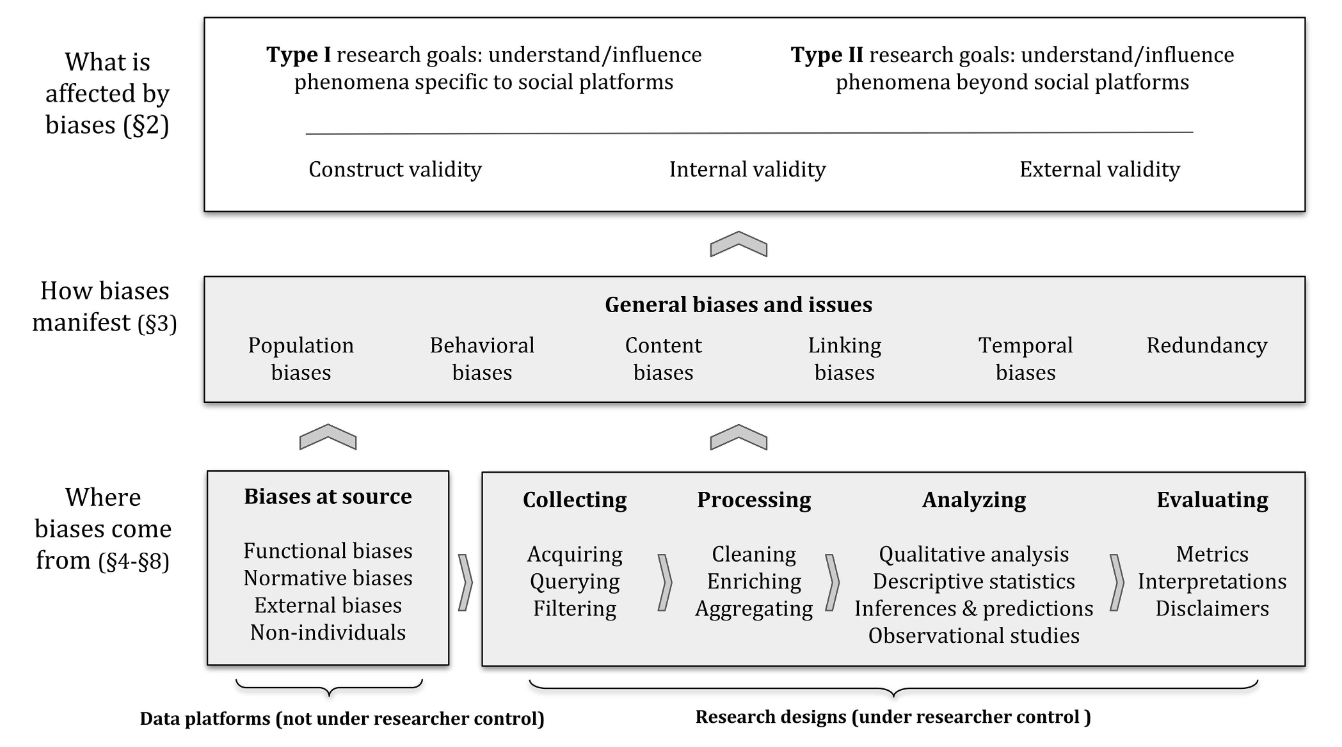

Spezifische und allgemeine Herausforderungen für die Forschung mit DBD

Hintergrund: (Big) Data ist zunehmend Grundlage für politische Maßnahmen, die Gestaltung von Produkten und Dienstleistungen und für die automatisierte Entscheidungsfindung

Herausforderungen in Bezug auf DBD-Forschung: fehlender Konsens über ein Vokabular oder eine Taxonomie, häufig nur impliziter Bezug in der Forschung

Generelle Herausforderung: bias ist ein weit gefasster & in unterschiedlichen Disziplinen genutzter Begriff

Was verstehen Sie unter “bias”?

Please participate!

Bitte scannen Sie den QR-Code oder nutzen Sie folgenden Link für die Teilnahme an einer kurzen Umfrage:

Temporary Access Code: 2359 9316

03:00

Ergebnis

Eher Konzept als Begriff

Zur Ambigutität des Begriffes bias und dessen Bedeutung im Seminar

- Problem: keine klare Grenzen zwischen den eher normativen Konnotationen (z.B. confirmation bias) und der statistischen Bedeutung des Begriffs (z.B. selection bias)

- Deswegen: Bewusstsein für Ambiguität des Begriffes

- Verwendung in vielen Disziplinen wie der Sozialwissenschaft, der kognitiven Psychologie oder dem Recht

- Untersuchung von verschiedenen Phänomenen, wie kognitive Voreingenommenheiten (Croskerry, 2002) sowie systemische, diskriminierende Ergebnisse (Friedman & Nissenbaum, 1996) oder Schäden (Barocas et al., 2017), aktuell z.B. bei der Verwendung von Machine Learning oder AI.

Verwendung des Begriff hauptsächlich in seiner statistischen Bedeutung, um auf Verzerrungen in sozialen Daten und deren Analysen hinzuweisen.

Know your bias!

Framework zur Minimierung von Fehlern und Problemen (Olteanu et al., 2019)

The biggest problem of them all

Potentielle Probleme mit der Qualität der Daten

Definition (Data bias) (Olteanu et al., 2019)

A systematic distortion in the sampled data that compromises its representativeness.

Sparsity: Häufig Heavy-Tail-Verteilung, was Analyse am “Kopf” (in Bezug auf häufige Elemente oder Phänomene) erleichtert, am “Schwanz” (wie seltene Elemente oder Phänomene) jedoch erschwert (Baeza-Yates, 2013)

Noise: Unvollständige, beschädigte, unzuverlässige oder unglaubwürdige Inhalte (boyd & Crawford, 2012; Naveed et al., 2011)

- Aber: Unterscheidung von “Noise” und “Signal” ist oft unklar und hängt von der Forschungsfrage ab (Salganik, 2018)

Organische vs gemessene Daten: Fragen zur Repräsentativität (vs. Stichprobenbeschreibung), Kausalität (vs. Korrelation) und Vorhersagegüte

Bias at the source

Potentielle Probleme mit der Datenquelle oder -herkunft

Biases, die auf das Design und die Möglichkeiten der Plattformen zurückzuführen sind (functional biases).

Verhaltensnormen, die auf den einzelnen Plattformen bestehen oder sich herausbilden (normative biases).

Faktoren, die außerhalb der sozialen Plattformen liegen, aber das Nutzerverhalten beeinflussen können (external biases)

Vorhandensein von nicht-individuellen Konten ein (non-individuals).

Gefangen im Spannungsverhältnis

Forschungethik bei digitalen Daten

Hintergrund: Die Herausforderung besteht in der Kombination von zwei extremen Sichtweisen, der Betrachtung der Forschung mit sozialen Daten als “klinische” Forschung oder als Computerforschung

Die Sozialdatenforschung unterscheidet sich von klinischen Versuchen.

Ethische Entscheidungen in der Sozialdatenforschung müssen gut überlegt sein, da oft sind mehrere Werte betroffen, die miteinander in Konflikt stehen können

Diskussion des Spannungsverhältnisses am Beispiel von drei spezifischer ethischer Kriterien: Autonomie, Wohltätigkeit und Gerechtigkeit

Achtung der individuellen Autonomie

Diskussion der Informierte Zustimmung als Indikator autonomer Entscheidung

Einwilligung nach Aufklärung setzt voraus, dass

- die Forscher*Innen den potenziellen Teilnehmenden alle relevanten Informationen offenlegen;

- die potenziellen Teilnehmenden in der Lage sind, diese Informationen zu bewerten;

- die potenziellen Teilnehmenden freiwillig entscheiden können, ob sie teilnehmen wollen oder nicht;

- die Teilnehmenden den Forschernden ihre ausdrückliche Erlaubnis erteilen, häufig in schriftlicher Form; und

- die Teilnehmende die Möglichkeit haben, ihre Einwilligung jederzeit zurückzuziehen.

Potentielle Probleme mit Blick auf DBD

Die Zustimmung von Millionen von Nutzern einzuholen ist nicht praktikabel.

Die Nutzungsbedingungen sozialer Plattformen stellen möglicherweise keine informierte Zustimmung zur Forschung dar.

Das öffentliche Teilen von Inhalten im Internet bedeutet nicht unbedingt eine Zustimmung zur Forschung.

No “No” ≠ “Yes”!

Ethische Erwägungen bei DBD-Forschung

Aus öffentlicher Zugänglich- bzw. Verfügbarkeit von Daten leitet sich nicht automatisch ethische Verwertbarkeit ab (boyd & Crawford, 2012; Zimmer, 2010)

Verletzung der Privatsphäre der Nutzer (Goroff, 2015)

Ermöglichung von rassischem, sozioökonomischem oder geschlechtsspezifischem Profiling (Barocas & Selbst, 2016)

Negative Beispiele

Facebook contagion experiment (2012-2014): Feeds von Nutzer*Innen so manipulierten, dass sie je nach den geäußerten Emotionen mehr oder weniger von bestimmten Inhalten enthielten (Kramer et al., 2014)

Encore-Forschungsprojekt: Messung der Internetzensur auf der ganzen Welt, bei der Webbrowser angewiesen wurden, zu versuchen, sensible Webinhalte ohne das Wissen oder die Zustimmung der Nutzer herunterzuladen (Burnett & Feamster, 2014)

Wohltätigkeit und Unschädlichkeit als Ziel

Bewertung von Risken & Nutzen

Hintergrund: Nicht nur Fokus auf den Nutzen der Forschung, sondern auch auf die möglichen Arten von Schäden, die betroffenen Gruppen und die Art und Weise, wie nachteilige Auswirkungen getestet werden können . (Sweeney, 2013)

Potentielle Probleme

Daten über Einzelpersonen können ihnen schaden, wenn sie offengelegt werden.

Forschungsergebnisse können verwendet werden, um Schaden anzurichten.

“Dual-Use”- und Sekundäranalysen sind in der Sozialdatenforschung immer häufiger anzutreffen.

Faire Verteilung von Risiken & Nutzen

Recht & Gerechtigkeit

Hintergrund: Häufig wird unterstellt bzw. angenommen, dass es von Anfang an bekannt, wer durch die Forschung belastet und wer von den Ergebnissen profitieren wird.

Potentielle Probleme

Die digitale Kluft kann das Forschungsdesign beeinflussen (z.B. WEIRD Samples)

Algorithmen und Forschungsergebnisse können zu Diskriminierung führen.

Forschungsergebnisse sind möglicherweise nicht allgemein zugänglich.

Nicht alle Interessengruppen werden über die Verwendung von Forschungsergebnissen konsultiert.

Zwei Trends, Drei Fragen, Vier Empfehlungen

Zusammenfassung und Ausblick

Trend 1: Skepsis gegenüber einfachen Antworten

Wie einstehen die Daten, was enthalten sie tatsächlich und wie sind die Arbeitsdatensätze zusammengestellt?

Wird deutlich, was ausgewertet wird?

Wird die Verwendung von vorhandenen Datensätzen und Modellen des maschinellen Lernens hinterfragt?

Trend 2: Wechsel von der Thematisierung zur Adressieung von Bedenken

Detaillierte Dokumentation und kritische Prüfung der Datensatz- und Modellerstellung

DBD-Studien auf verschiedene Plattformen, Themen, Zeitpunkte und Teilpopulationen auszuweiten, um festzustellen, wie sich die Ergebnisse beispielsweise in verschiedenen kulturellen, demografischen und verhaltensbezogenen Kontexten unterscheiden

Transparenzmechanismen zu schaffen, die es ermöglichen, Online-Plattformen zu überprüfen und Verzerrungen in Daten an der Quelle zu evaluieren

Forschung zu diesen Leitlinien, Standards, Methoden und Protokollen auszuweiten und ihre Übernahme zu fördern.